Présentée comme moteur d’innovation et de croissance pour les entreprises, l’IA doit aujourd’hui tenir ses promesses. Il faut déployer les algorithmes en production et industrialiser leur cycle de vie pour espérer atteindre les ROI tant attendus. Il est temps de passer à MLOps.

Le temps des expérimentations et des PoC sans lendemain s’achève pour l’IA en entreprise. Les Comex veulent désormais des résultats et commencer à tirer profit des efforts consentis ces dernières années. Les promesses des grands cabinets d’analystes sur l’IA doivent être tenues et le seul moyen d’y parvenir est d’industrialiser non seulement pour créer et réaliser l’apprentissage de modèles de Machine Learning, mais aussi et surtout les porter jusqu’en production, puis en assurer la gestion des performances. Au même titre qu’il faut gérer le cycle de vie des logiciels, il faut suivre celui des modèles d’intelligence artificielle encore plus étroitement, sachant que les modèles d’IA peuvent être affligés de baisses de performances dans le temps. « Une enquête auprès de nos clients a montré que seulement 20 % des modèles d’IA parviennent jusqu’à la production » racontait ainsi Subhadip Roy, Head of Machine Learning Engineering, AI, & Data chez Deloitte, lors de l’événement « Everyday AI » organisé récemment à Londres par Dataiku. « Il est temps de comprendre qu’on ne peut demander au data scientist de produire du code pour la production, c’est à un ingénieur software de l’écrire. C’est là qu’intervient MLOps, à l’intersection entre Data Science, Data Engineering et DevOps. Il s’agit de porter des modèles en production de façon fiable, sécurisée via un pipeline, mais aussi avoir un mécanisme pour gérer les modèles qui sont déjà en production. »

> Si bon nombre d’entreprises se sont dotées de studios de conception afin de créer les algorithmes et modèles d’IA, il ne s’agit que de la partie émergée de l’iceberg MLOps.

> Si bon nombre d’entreprises se sont dotées de studios de conception afin de créer les algorithmes et modèles d’IA, il ne s’agit que de la partie émergée de l’iceberg MLOps.

Vers une industrialisation du cycle de vie des algorithmes

De très nombreux éditeurs de solution de Data Science, à l’image du français Dataiku, ont étendu la couverture fonctionnelle de leurs outils pour couvrir l’intégralité du cycle de vie des modèles d’IA. La stratégie de l’éditeur est de se positionner sur 4 étapes clés du MLOps, à savoir la préparation des données, la conception des modèles, leur déploiement, puis le monitoring et la supervision des algorithmes et des inférences. David Talaga, directeur du marketing produit chez Dataiku, souligne : « Dataiku offre à la fois des fonctionnalités simples et universelles pour couvrir la découverte et le traitement des données, le déploiement, le monitoring et la gouvernance des projets d’intelligence artificielle au sein d’un système ouvert et adaptatif tirant parti des infrastructures cloud les plus modernes. Au-delà de cette vision très linéaire du MLOps, notre vision est que le MLOps est une approche visant à intégrer les contraintes d’opérationnalisation dès le début du projet, de manière naturelle et sans imposer de gros effort de redesign en arrivant à l’étape du déploiement. »

Pour Florent Pietot, cofondateur de Nibble.ai, s’appuyer sur une plateforme unifiée ne suffit pas au succès d’une stratégie MLOps. « Les composantes culturelles et organisationnelles sont essentielles dans la mise en place d’une démarche MLOps. Cela constitue le socle fondamental sous-tendant les process et les outils. » L’expert souligne que ces projets MLOps sont beaucoup plus coûteux que ce que l’on imagine au départ, une sous-estimation bien supérieure à celle du coût d’un logiciel du fait de la complexité induite par la gestion des algorithmes.

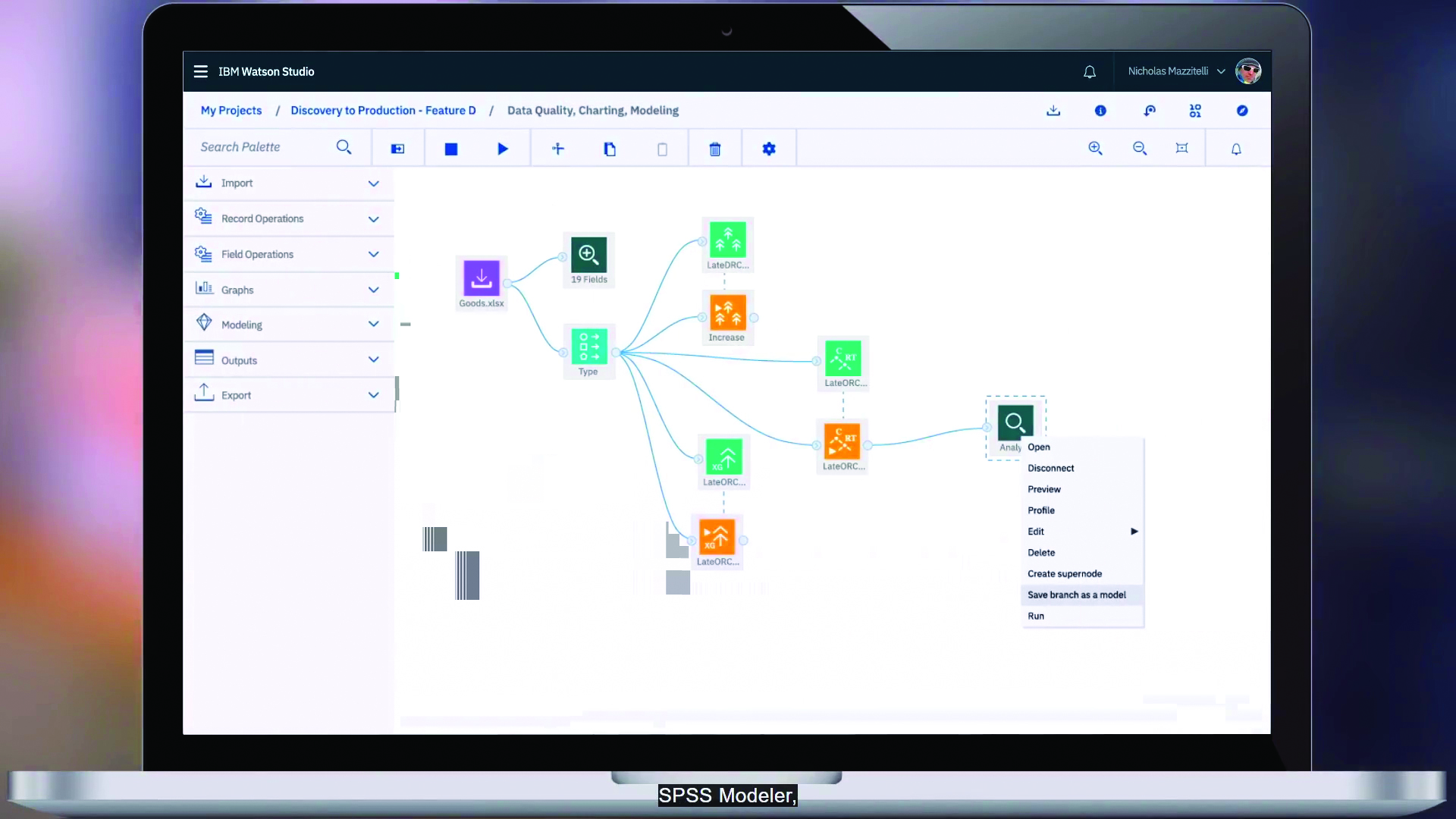

> Le cycle MLOps enrichi par Satish Chandra Gupta.

> Le cycle MLOps enrichi par Satish Chandra Gupta.

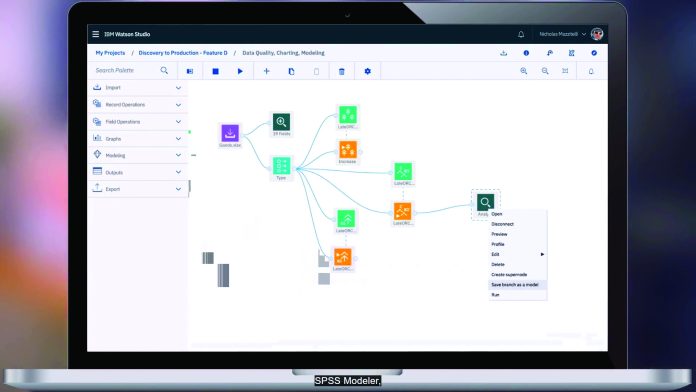

Autre acteur de poids du Big Data, Alteryx propose avec Analytics Cloud une plateforme end-to-end qui couvre toutes les étapes du MLOps, depuis la création de modèles de Machine Learning, jusqu’à leur gestion, leur déploiement et enfin leur suivi. Cette solution fournit les connecteurs de données, les Building Blocks, ainsi que les fonctionnalités nécessaires pour créer, développer et déployer des solutions de modélisation avec très peu (voire pas du tout) de codage requis de la part du développeur.

« En moyenne, entre 60 et 80 % des modèles construits dans l’intention d’être déployés ne le sont jamais » déplore Raphaël Savy, vice-président France et Europe du Sud d’Alteryx. « Il faut généralement six à huit mois pour déployer un modèle, lui laissant le temps de devenir obsolète. En résumé, les organisations perdent du temps et de l’argent dans des projets de Data Science qui ne fonctionnent pas ou ne sont jamais mis en production. C’est là qu’Alteryx intervient. Notre solution permet des MLOps intuitifs pour réduire le risque d’échec. » L’éditeur a voulu rassembler les processus critiques de préparation et de mélange des données, de construction de modèles de Machine Learning et de MLOps pour aider les organisations à passer plus rapidement des données entrées aux informations et aux résultats.

Outre ces pure players venus du Big Data et des Data Sciences, de nombreux éditeurs de logiciels ont cherché à prendre le train en marche. HPE a ainsi multiplié les acquisitions ces dernières années notamment celles de BlueData et MapR afin de monter son offre Ezmeral. « La solution Ezmeral Unified Analytics couvre la totalité du cycle MLOps » estime Pierre Hoffer, Senior Director EMEA Technical Sales HPC & AI chez Hewlett Packard Enterprise.

« Les logiciels MLDM et MLDE couvrent les volets Data Extraction, Data Validation et Data Préparation, le développement et l’expérimentation des modèles, leur apprentissage, leur scoring et leur validation et enfin la mise en production et le monitoring en production. » Tout en jouant sur la carte Open Source, le responsable considère que la force de la solution HPE Ezmeral est de fournir ces mêmes logiciels, packagés, testés, intégrés, validés et supportés par HPE.

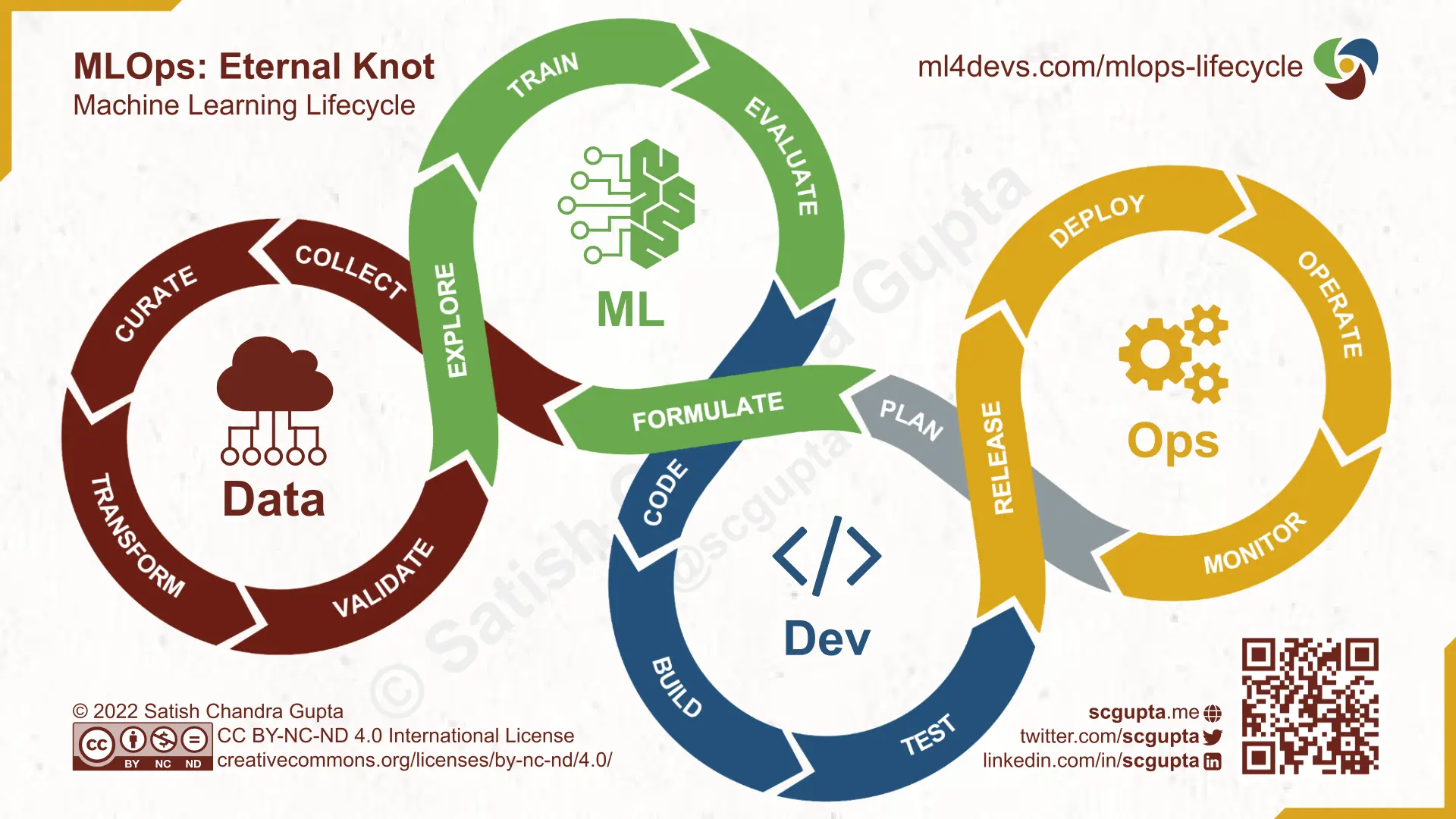

> Contrairement à l’exploitation d’une application classique, il est nécessaire de monitorer la performance de prédiction de l’algorithme dans la durée afin d’intervenir si celle-ci vient à décliner et mener un réapprentissage du modèle sur des données plus récentes.

> Contrairement à l’exploitation d’une application classique, il est nécessaire de monitorer la performance de prédiction de l’algorithme dans la durée afin d’intervenir si celle-ci vient à décliner et mener un réapprentissage du modèle sur des données plus récentes.

Des éditeurs en coopétition avec les hyperscalers

Quelle que soit leur origine, tous ces éditeurs doivent cohabiter avec des acteurs incontournables de l’IA, les hyperscalers. Non seulement les entreprises comptent sur leurs infrastructures pour accéder à des GPU à faible coût afin d’entraîner leurs modèles, mais tous les hyperscalers proposent eux-mêmes des plateformes MLOps complètes. David Talaga considère que Dataiku n’est pas en concurrence directe avec ces acteurs : « Nous estimons qu’une grande partie du marché, et la totalité des grands comptes, possèdent plusieurs plateformes d’IA (dédiées ou non). Les hyperscalers sont bien sûr très présents dans cet écosystème hétérogène, mais nous pensons aussi que c’est une situation amenée à durer, pour de multiples raisons (technologiques, économiques, organisationnelles), de la même manière que les infrastructures IT hybrides, voire multicloud, sont devenues la norme, et non la convergence vers une seule et unique plateforme. » L’éditeur, comme nombre de ses concurrents, a développé des capacités d’intégration des ressources Cloud des hyperscalers pour faciliter la tâche de ses clients à la recherche des ressources de calcul au ratio prix/performance le plus compétitif.

Alors que les concepts MLOps se diffusent peu à peu dans les entreprises, déjà la prochaine évolution de l’approche pointe à l’horizon, comme l’explique Subhadip Roy : « Le prochain défi sera AIOps, une évolution de MLOps. Il y aura toujours des humains dans la boucle pour créer les pipelines, les maintenir et gérer les problèmes en production, mais une grande partie de MLOps pourra être automatisée. L’IA va devenir prédominante, ne serait-ce que pour surveiller les modèles en production et s’assurer que ceux-ci ne dérivent pas. »

________________________________________________________________________

➜ Témoignage

L’objectif est de rendre les data scientists autonomes pour faire passer leurs applications en production »

L’objectif est de rendre les data scientists autonomes pour faire passer leurs applications en production »

Nicolas Cornet, Head of Data & AI Engineering

chez Saint Gobain Group

« Nous avons 75 data scientists répartis dans 16 business units, qui assurent plus de 100 projets par an. 4 accélérateurs créés en 2022 pour les supporter : un portail dédié à l’IA pour faciliter les échanges entre data scientists, deux plateformes pour créer les algorithmes : AI Lab pour le prototyping d’applications sur Azure, AI Indus pour le passage en production des applications et enfin un AI Store pour favoriser la réutilisation des applications et modèles.

Pour IA Lab, nous avons standardisé la façon de structurer le code sur Git. Nous avons aujourd’hui une quinzaine de services Azure qui sont instanciés automatiquement par un script Terraform. Nous fournissons des pipelines standards. Pour la partie déploiement qui est un peu technique pour un Data Scientists, nous avons automatisé cette partie : avec quelques paramètres simples, l’intégralité du code est dockerisée et exposée sur Kubernetes, à la fois le modèle de Machine Learning et la partie frontend/UI. IA Lab travaille en combinaison avec AI Indus qui gère les environnements post-prototyping.

Nous avons développé l’AI store, notre bibliothèque interne de Data Science, avec des applications sur étagère, prêtes à être déployées en production. Des applications déployées avec succès sur une Business Unit sont repackagées, rendues plus génériques afin de pouvoir être redeployées de manière extrêmement rapide.

Ces 4 accélérateurs ont été montés en 9 mois, par une petite équipe de 4 Machine Learning Engineers qui ont travaillé à temps plein sur le sujet, mais autour de cette équipe, nous avons pu nous appuyer sur tout un écosystème Saint Gobain pour construire ces accélérateurs.

Nous avons poussé très loin l’industrialisation de la partie Data Science sur le Cloud Azure et nous adressons de plus en plus de scénarios typés industriels. Nous souhaitons maintenant standardiser les pratiques inter-BU, car il faut faire le lien entre les technologies OT, les Digital Twins et le déploiement d’algorithmes en Edge pour les cas d’usage qui ne tolèrent pas de latence entre le Cloud et l’usine. »