Les établissements publics comme privés ont chacun leurs propres contraintes et règles de sécurité à faire appliquer. Par conséquent, il convient de commencer par un état des lieux.

« On ne peut pas s’affranchir de l’analyse des risques, dans toute transition vers le Cloud. C’est aussi essentiel que la formation des utilisateurs à alerter sur la confidentialité des mots de passe, la gestion des droits et des habilitations », confirme Vincent Gervais, consultant en sécurité du SI chez Devoteam.

Comment faire évoluer les plans de sauvegarde dans ce contexte multi-Cloud ? « Nos clients semblent prêts à sauvegarder leurs données sur un Cloud public, dès lors que celles-ci sont chiffrées, sans crainte particulière à présent. C’est là qu’ils trouvent les capacités les moins coûteuses. Depuis quelques semaines, les entreprises de taille moyenne à grande, avec de forts enjeux de sécurité, tiennent aussi à se mettre en conformité avec le RGPD. En termes d’exigences techniques, cela requiert des contrôles permanents et une visibilité plus forte sur les flux de données. »

L’obligation de rendre publiques les fuites de données à caractère personnel devrait provoquer une augmentation de la demande en outils de détection et de prévention. « Dès le printemps 2018, les entreprises devront adapter leurs procédures de transparence, s’équiper d’outils de détection avancés en temps réel avec des facultés de reporting, prévient Bernard Montel, directeur technique cybersécurité de RSA en Europe continentale. Pour anticiper l’évolution de la réglementation, nos clients s’équipent pour savoir ce qui se passe sur leurs données et être en capacité de démontrer qu’ils ne subissent pas de fuites, leurs incidents étant traités comme il convient. L’entreprise doit s’organiser, bien identifier son périmètre à risque et le surveiller à tout instant. Cette culture de la protection est omniprésente en Allemagne plus qu’en France », compare-t-il.

« Dans toutes transitions vers le Cloud, impossible de s’affranchir de l’analyse des risques. »

Vincent Gervais

Protection et suivi des données vont de pair

Suivre le cycle de vie des données forme une bonne approche de mise en conformité au règlement RGPD. Après l’état des lieux, c’est un pas en avant précieux pour mieux connaître ses informations et leurs parcours. Cette étape prépare les déplacements de données au cœur des baies de stockage, ou automatiquement entre plusieurs datacenters. Faut-il généraliser cette pratique et sur quels critères ? « La gestion du cycle de vie de la donnée (ILM) est une activité transverse, qui ne concerne pas seulement le Cloud, observe Julien Mousqueton, responsable chez Computacenter des offres datacenter. L’ILM distingue les données froides, tièdes et chaudes afin de provoquer leur déplacement en fonction de leur usage et du coût du stockage. Certaines baies de stockage sont performantes sur l’auto-tiering. Selon les besoins, un équipement dédié baptisé “Data Mover” s’avère plus efficace pour le stockage de fichiers par taux d’accès que l’auto-tiering des baies qui intervient au niveau des blocs de données ». Faut-il conjointement classer, chiffrer, tracer et sauvegarder ses données ? « Pour ce qui concerne le chiffrement de données, il convient surtout de trouver le bon équilibre entre ce qui peut rejoindre le Cloud et ce qui doit demeurer dans l’entreprise, comme les clés privées », nuance Julien Mousqueton. Prendre la problématique dans son ensemble permet de vérifier où sont les meilleures compétences et les bonnes mesures de protection, dans l’entreprise ou chez un prestataire spécialisé. « Je rencontre des tentatives d’amélioration de la sécurité par l’externalisation, confirme Bernard Montel, la cryptologie répond à un besoin bien particulier de chiffrer les données pures. Les agences gouvernementales et les entreprises expriment un besoin de surveillance plus que de scellement des données. C’est lorsque la donnée est manipulée, partagée, puis transférée qu’elle devient vulnérable. »

Vers une surveillance continue

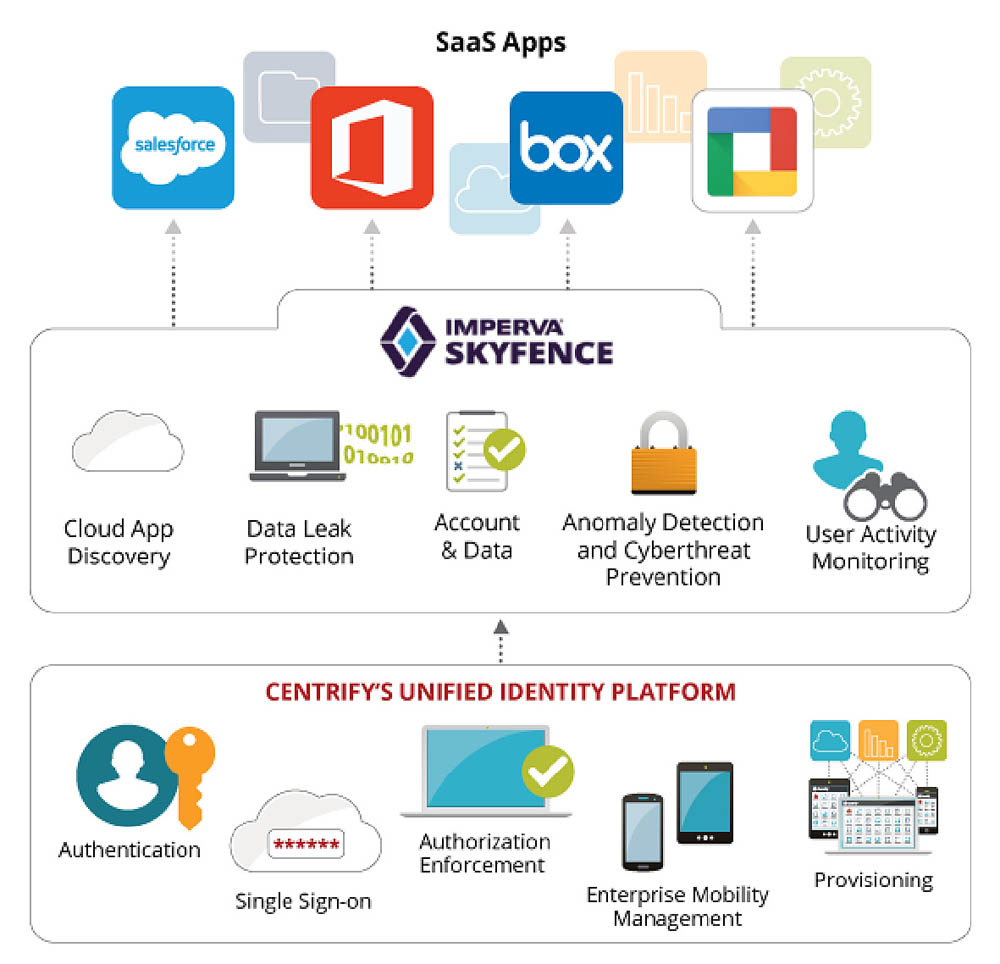

Le soutien d’un SOC (Security Operation Center) contribue à surveiller, au-delà du périmètre interne, les malveillances et maladresses susceptibles de détourner les données numériques. Au niveau du Cloud hybride, l’analyse porte sur un nombre croissant de flux d’informations, composés notamment de journaux systèmes et réseaux. « Les logs d’accès, les conteneurs du prestataire, les journaux d’équipements réseaux et les API des grands Clouds doivent être exploités pour garantir une visibilité de même niveau sur les infrastructures internes et Cloud, de sorte à déjouer les attaques », explique Bernard Montel. Il recense d’ailleurs trois sources d’informations à réunir pour une bonne détection des menaces : la capture des flux réseaux, la surveillance des terminaux et l’analyse des journaux générés par les équipements de sécurité.

Les solutions de stockage tranformées par le SDS

La sécurité par conception transforme également les solutions de stockage. Avec l’approche SDS (Software-Defined Storage) ce sont plusieurs Péta-octets qui sont protégés par la solution du français Scality, fournisseur d’opérateurs, de prestataires Cloud, d’agences gouvernementales et de laboratoires de recherche. Son logiciel Ring 6.4 s’appuie sur des plateformes matérielles standards et assure la protection des données en environnement Cloud hybride.

Lancée fin février, l’offre de services Halo procure une plateforme de supervision dans le Cloud, opérée par l’éditeur lui-même. « En confiant une partie de leurs données à un prestataire et en conservant le reste en local, nos clients veulent s’assurer que leurs applications et leurs utilisateurs auront toujours accès aux données, explique Daniel Binsfeld, vice-président DevOps et Global Support de Scality. Grâce à Halo et à d’autres services, nous supervisons le Ring et garantissons une disponibilité à 100 % des données. Notre logiciel est adapté au stockage primaire comme à la sauvegarde de données. C’est le cas chez GE, par exemple, où le Ring devient un pool générique de stockage. Toutes les applications vont le consommer, les clichés d’IRM étant considérées comme très sensibles et les PC de l’administration aussi, chacun y trouvant un backup avec des politiques et des règles de placement distinctes »

« En confiant une partie de leurs données à un prestataire et en conservant le reste en local, nos clients veulent s’assurer que leurs applications et leurs utilisateurs auront toujours accès aux données. »

Daniel Binsfield, Scality