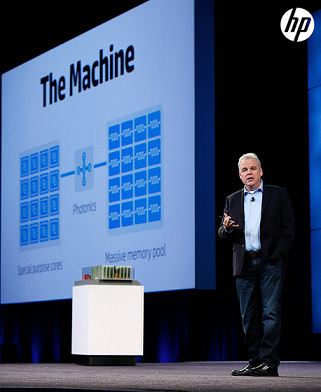

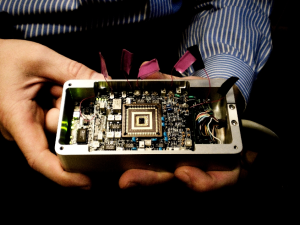

Lors de Discover 2014, Martin Fink, directeur technique d’HPE, dévoilait les grandes lignes du projet « The Machine ».

Véritable serpent de mer chez HPE, le projet d’ordinateur du futur « The Machine » réapparait périodiquement, lors des conférences HPE Discover. Le constructeur n’a toujours pas dévoilé son prototype, mais les premières briques logicielles sont disponibles en Open Source.

Depuis quelques semaines, HPE recommence à parler de « The Machine », un projet mené dans les très secrets Hewlett Packard Labs. L’objectif fixé aux ingénieurs n’est rien moins que de réinventer l’ordinateur tel que nous le connaissons aujourd’hui.

Un projet dont un premier prototype est théoriquement attendu pour cette année mais sur lequel les ingénieurs des « Labs » d’HP travaillent depuis le début des années 2000 comme le rappelle Patrick Demichel, architecte système auprès de la division Hyperscale d’HPE EMEA « C’est au début des années 2000 que la communauté a commencé le travail sur la génération des supercalculateurs exaflopiques attendue pour l’horizon 2020. Les simulations d’alors montraient alors que pour atteindre une telle puissance, l’énergie consommée serait de l’ordre de plusieurs centaines de Mégawatts. » Une telle puissance rend la construction d’un calculateur exaflopique un non-sens économique, ce qui a poussé les chercheurs à se fixer l’objectif de limiter la consommation électrique à 20 MW pour atteindre la barre de l’exaflop (1 000 petaflops). A titre d’exemple, l’ordinateur le plus puissant au monde, le tout récent Sunway TaihuLight chinois, offre une puissance de 93 petaflops pour une consommation de 15,37 MW.

Les technologies photoniques se font attendre

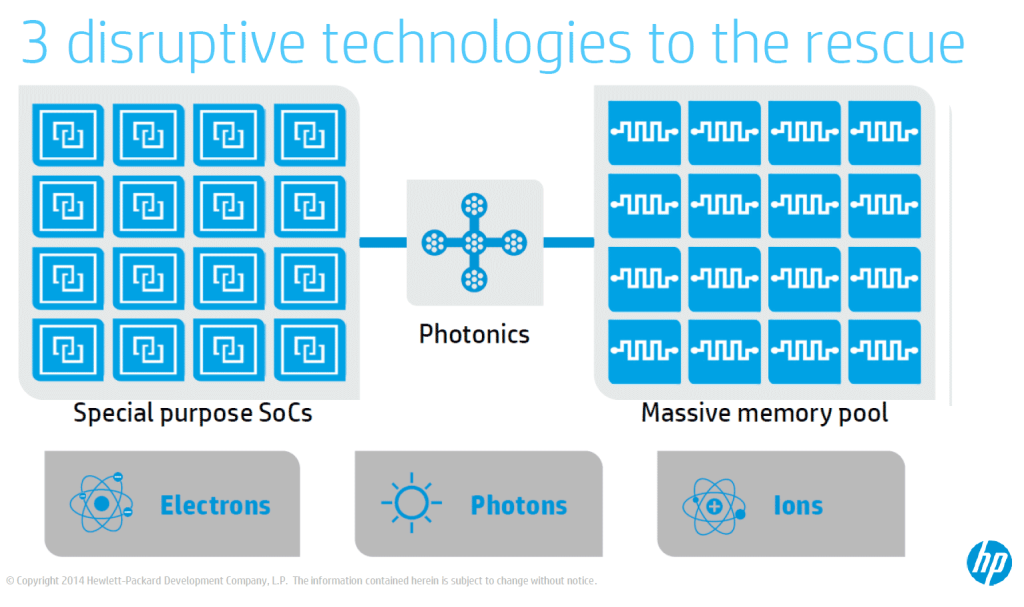

Atteindre les 1 000 pet flops tout en restant sous la barre des 20 MW est donc hors de portée des technologies actuelles, même les plus en pointe. « La décision a été prise d’explorer trois technologie fondatrices qui sont aujourd’hui au cœur du projet The Machine« , explique Patrick Demichel, « à savoir les mémoires non volatiles, la photonique et les processeurs à basse consommation. » En 2008, les HP Labs publient un premier article de recherche qui fait état du projet Corona, un projet qui vise à mettre au point un processeur photonique de 256 cœurs devant être commercialisé à l’horizon 2017. « Il s’agit d’une recherche sur le long terme. La photonique est une technologie disruptive et les recherches avancent, mais le grand challenge est de produire ces composants à faire cout. » Près d’une décennie plus tard, le projet reste encore dans les laboratoires, même si quelques composants photoniques ont été présentés lors de HPE Discover 2015. « La recherche travaille sur des cycles longs, avec la réalisation d’une vision sur 10 ans, 20 ans, parfois » explique Patrick Demichel. « La phase de développement qui vient ensuite est plus rapide, de l’ordre de 2 à 3 ans. C’est le moment où l’on a trouvé les solutions mais qu’il faut les réaliser et produire à faible coût.«

Les Memristor imposent de repenser le logiciel

Si les processeurs et bus de données photoniques ne sont pas encore opérationnels, le développement des mémoires de type memristor ou mémoires non volatiles (NVM) est l’objet d’une intense compétition. Ces mémoires, bien plus rapides que les mémoires Flash des disques SSD actuels, doivent permettre de simplifier drastiquement l’architecture de l’ordinateur du futur selon Patrick Demichel : « La disponibilité de mémoires rapides qui vont remplacer disques durs et SSD couplée à des bus de données photoniques à très haute performance et faible latence vont permettre de simplifier les OS, réduire la complexité des architectures pour les développeurs. La mise en place de pool de ressources mémoire, de pool de ressource de calcul va permettre d’imaginer une simplification des applications. »

L’édition 2016 d’HPE Discover n’a pas été l’occasion de voir le premier prototype de « The Machine » mais l’américain en a profité pour diffuser en Open Source diverses briques logicielles de la future machine. Parmi les 4 projets ouverts aux communautés Open Source figure FOEDUS (pour Fast Optimistic Engine for Data Unification Services), une base de données clé/valeur imaginée pour tirer profit des memristor. Les autres projets sont essentiellement des simulateurs qui doivent permettre aux développeurs de créer des applications pour les ordinateurs à base de memristor en émulant leur comportement sur des machines classiques. HPE veut préparer les développeurs à une architecture d’ordinateur qui place non plus le processeur au centre, mais cette mémoire non volatile. HPE met peu à peu les éléments en place pour préparer l’arrivée de « The Machine » mais le constructeur parviendra-t-il à présenter un prototype cette année et lesquels de ses trois technologies fondatrices seront à l’appel ? La question reste posée.

Du supercalculateur au capteur intelligent il n’y a qu’un pas

Aujourd’hui HPE évoque de nouveaux usages pour « The Machine ». Le projet semblait au départ destiné au domaine du calcul intensif, de ces quelques machines ultra-puissantes capables de calculer les prévisions météo, les simulations d’explosions nucléaires ou la vie des galaxies. Depuis, un nouveau champ d’application est apparu, c’est celui de l’Internet des objets. La perspective de devoir gérer les données générées par les 30 milliards d’objets connectés attendus pour 2020 ouvre de nouvelles perspectives pour les technologies développées pour « The Machine ».

« La volumétrie des données que vont représenter ces milliards d’objets connectés va représenter un challenge majeur« , estime Patrick Demichel. « L’idée est de réduire ce volume de données in-situ, au niveau même du capteur afin de n’envoyer sur les réseaux que des métadonnées, que les informations qui seront significatives pour les algorithmes. C’est une vision holistique, une vision globale qui porte sur une approche dans son ensemble et pas uniquement dans l’optimisation d’un ou de quelques éléments d’architecture. » Tout comme dans le monde du calcul intensif, le challenge porte sur la consommation électrique, à une toute autre échelle il est vrai. « Il va falloir aller vers des processeurs très spécialisés et conçus spécifiquement pour une tâche à accomplir » considère Patrick Demichel, « des processeurs qui ne consommeront que quelques microwatts afin de les placer ai plus près des capteurs. » Ces microprocesseurs devront à la fois effectuer un traitement des données brutes de premier niveau, mais aussi le chiffrement des données. HPE commercialise déjà des gateways, des mini-serveurs à déployer sur le terrain, mais l’approche reste techniquement encore très traditionnelle puisqu’il s’agit de petites machines architecturée autour d’un processeur Intel Atom. HPE estime que dans quelques années, ces équipements seront totalement intégrés aux produits et aux infrastructures. Illustration de cette vision, le projet CeNSE (Central Nervous System for the Earth) lancé par les HP Labs dès 2009 pour mesurer les séismes. HPE évoquait déjà la possibilité d’équiper le pont du Golden Gate de 10 000 de ces capteurs communicants.

Les ingénieurs des HP Labs fourmillent d’idées pour inventer l’informatique de demain, mais leur concrétisation en produits commerciaux semble toujours aussi complexe. Rendez-vous en fin d’année pour voir si leurs promesses seront tenues.

Auteur : Alain Clapaud