AWS veut simplifier l’intégration des objets connectés à son Cloud

Dès 2017, Amazon Web Services dévoilait ses ambitions en misant sur FreeRTOS, un système d’exploitation embarqué Open Source notamment utilisé dans certains objets connectés. Stephan Hadinger, Head of Technology d’AWS France explique cette démarche : « Nous avons investi dans la fondation et développé quelques couches critiques additionnelles, notamment dans la sécurité. Cet OS est destiné à des équipements amenés à fonctionner dans des environnements non surveillés, comme des gares, dans la rue. Le chiffrement des données doit être réalisé en amont afin que les données transmises ne puissent être interceptées et interprétées par qui que ce soit. »

« Les entreprises vont aujourd’hui vers des architectures hybrides, l’Edge Computing venant compléter le Cloud public pour les applications nécessitant de très faibles temps de latence et des applications qui ne tolèrent pas d’arrêt en cas de coupure réseau » Stephan Hadinger

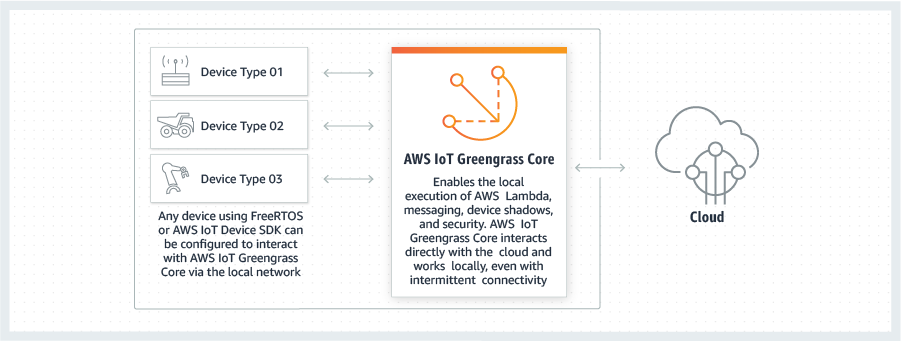

Autre fonction clé, les mises à jour OTA (Over The Air) qui doivent permettre de réaliser le patching de ces équipements à distance, y compris via des réseaux IoT ne présentant qu’un très faible débit montant. L’objectif d’AWS est très clair : faciliter le travail des concepteurs d’objets connectés et ainsi alimenter son service AWS IoT Greengrass des données générées par leurs réalisations. FreeRTOS est un moyen d’alimenter le Cloud d’Amazon, mais ce n’est pas le seul. Le développeur peut aussi faire le choix du SDK AWS IoT Device, un kit de développement déployable sur de multiples plateformes dont Raspberry Pi. Il permet de collecter et envoyer des données à partir d’un simple microcontrôleur, il implémente aussi des fonctions de gestion à distance du terminal, le support de multiples protocoles industriels afin de retransmettre les données prétraitées vers le Cloud via MQTT. « Le vrai intérêt réside dans la capacité de cette solution à exécuter une fonction lambda en local. Les développeurs n’ont pas à réécrire leur logiciel embarqué pour chaque type d’objet et, surtout, celui-ci fonctionne en local et peut continuer à fonctionner si l’usine se retrouve déconnectée d’Internet », explique Stephan Hadinger.

instances EC2 ou des fonctions lambda et même un GPU pour exécuter des inférences de Machine Learning. « Installer un rack de serveurs et de stockage impose de disposer d’une salle blanche climatisée, ce dont ne disposent pas nécessairement les industriels sur tous leurs sites. Snowball Edge répond à ce besoin et peut être installé dans un atelier, dans un bateau. Certaines entreprises ont même déployé une noria de 5 Snowball et fonctionnent par roulement, lorsque le stockage d’un Snowball est complet, le stockage passe au suivant. »

Installer une région AWS dans son entreprise, c’est possible

Lorsque le besoin en termes de traitement ou de stockage est supérieur, AWS propose l’offre AWS Outposts, un rack prêt à l’usage. Il s’agit d’un rack complet avec de la puissance de traitement, du stockage et un switch de type « Top of Rack ». L’américain propose 5 grandes configurations matérielles différentes, selon que l’entreprise veut déployer des instances plus d’instance large et une capacité de stockage différente. Ces racks sont proposés en location pure, facturés au mois, ou à l’achat. « Il s’agit des mêmes serveurs que ceux déployés dans nos datacenters avec une demi-douzaine de services AWS. L’entreprise peut décider d’activer ses services dans notre Cloud public ou en local sans aucune contrainte. Il s’agit d’une région spécifique à l’entreprise et le développeur peut choisir de déployer son application sur cette région ou sur une région classique d’AWS sans aucune contrainte d’adaptation de son application. Il s’agit d’un service : Nous nous chargeons des mises à jour et de la supervision de la plateforme, l’entreprise n’a rien à faire d’autre. »

AWS Outposts supporte aujourd’hui les instances EC2, l’hébergement de conteneurs sur Amazon ECS (Elastic Container Service) ou Amazon EKS (Elastic Kubernetes Service), le stockage Amazon EBS (Elastic Block Store), et la distribution Hadoop Amazon EMR. La base de données Amazon RDS est encore en preview. Le service de stockage Amazon S3 devrait rapidement enrichir ce portefeuille de services encore très limité si on le compare au portefeuille de services proposés par AWS sur son Cloud public. Détail technique intéressant, toutes les données stockées sur un rack Outposts sont chiffrées via l’architecture Nitro d’AWS. Un coup de tournevis sur un petit module amovible, il est possible de détruire physiquement la puce qui contient la clé de chiffrement des disques et ainsi être sûr que les données ne réapparaitront pas lorsque si l’entreprise décide de rendre son rack à AWS.